MAGI-1是什么

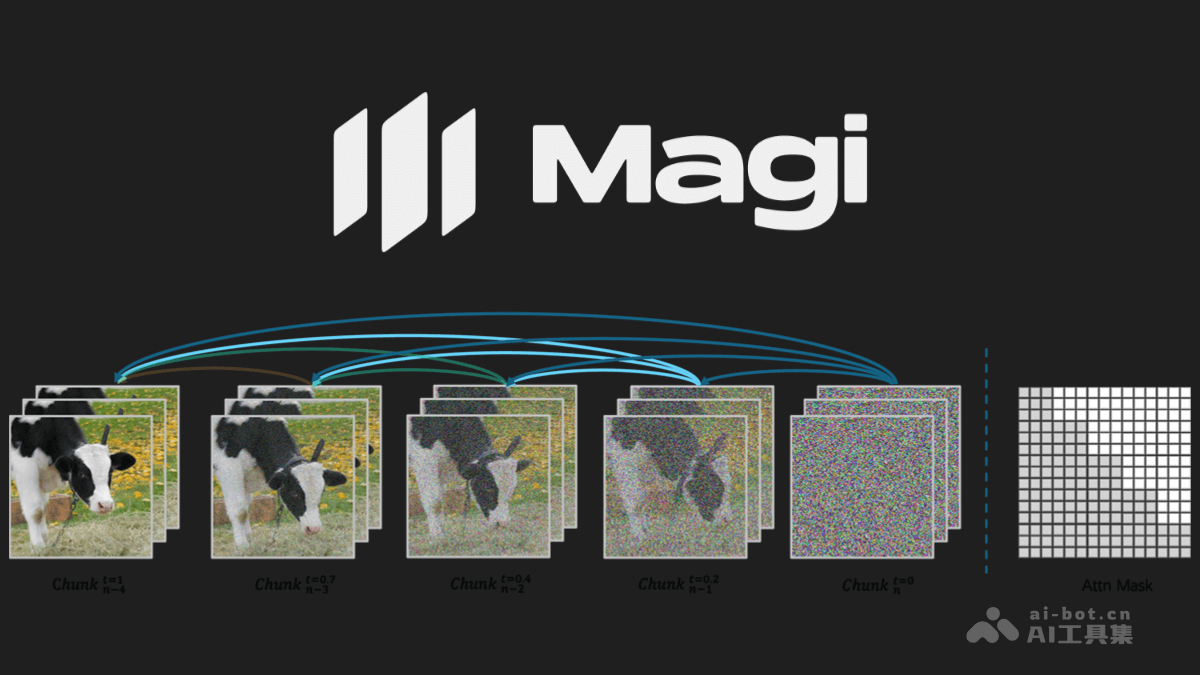

MAGI-1 是 Sand AI 开源的全球首个自回归视频生成大模型,采用自回归架构,通过逐块预测视频序列生成流畅自然的视频,支持无限扩展和一镜到底的长视频生成。模型原生分辨率可达 1440×2568,生成的视频动作流畅且细节逼真,具备可控生成能力,可通过分块提示实现平滑场景转换和细粒度控制。

MAGI-1的主要功能

- 高效视频生成:MAGI-1 能在短时间内生成高质量视频片段,例如生成 5 秒视频仅需 3 秒,生成 1 分钟视频可在 1 分钟内完成。通过分块生成(每块 24 帧)的方式,逐块去噪并并行处理,大幅提升生成效率。

- 高保真输出:生成的视频具有高分辨率(原生 1440×2568),动作流畅且细节逼真,适合多种高质量视频创作需求。

- 无限扩展与时间轴控制:支持无限长度扩展,可无缝续写生成连续长视频场景,具备秒级时间轴控制能力,用户可以通过逐块提示实现精细化的场景转换和编辑。

- 可控生成:通过分块提示,MAGI-1 支持平滑的场景过渡、长视距合成和细粒度的文本驱动控制,能根据文本指令生成符合用户需求的视频内容。

- 物理行为预测:在物理行为预测方面表现出色,能生成符合物理规律的动作和场景,适合复杂动态场景的生成。

- 实时部署与灵活推理:支持实时流式视频生成,同时适配多种硬件配置,包括单张 RTX 4090 GPU 的部署,降低了使用门槛。

MAGI-1的技术原理

- 自回归去噪算法:MAGI-1 采用自回归去噪的方式生成视频,将视频划分为固定长度的片段(每块 24 帧),逐块进行去噪处理。当前一个片段达到一定去噪水平后,便开始生成下一个片段。这种流水线设计最多可同时处理四个片段,大幅提升了生成效率。

- 基于 Transformer 的 VAE:模型使用基于 Transformer 架构的变分自编码器(VAE),实现了 8 倍空间压缩和 4 倍时间压缩。解码速度快,具备高竞争力的重建质量。

- 扩散模型架构:MAGI-1 基于 Diffusion Transformer 构建,融入了多项创新技术,如块因果注意力、并行注意力块、QK-Norm 和 GQA、三明治归一化、SwiGLU 和 Softcap Modulation 等。提高了大规模训练的效率和稳定性。

- 蒸馏算法:MAGI-1 采用了一种高效的蒸馏方法,训练了一个基于速度的模型,支持不同的推理预算。通过强制执行自一致性约束(将一个大步长等同于两个小步长),模型能在多个步长范围内逼近流匹配轨迹,实现高效推理。

MAGI-1的项目地址

MAGI-1的应用场景

- 内容创作:MAGI-1 为视频内容创作者提供了高效的视频生成工具,能根据文本指令快速生成高质量的视频内容。创作者可以通过简单的提示词生成各种场景的视频片段,如自然风光、人物动作等,提高了创作效率。

- 影视制作:在影视制作中,MAGI-1 可以用于生成复杂的特效场景,帮助电影制作人员快速实现创意构思。“无限视频扩展”功能允许无缝延长视频内容,结合“秒级时间轴控制”,能实现精细化的场景转换和编辑,满足长篇叙事的需求。

- 游戏开发:MAGI-1 可用于生成动态背景和场景,增强游戏的沉浸感和视觉效果。通过实时流式视频生成技术,游戏开发者可以在游戏中实现更加自然和流畅的动画效果。

- 教育:MAGI-1 可以生成生动的教育视频,帮助教育工作者以更直观的方式传授知识。

- 广告与营销:MAGI-1 能快速生成高质量的广告视频,根据品牌需求生成符合主题的动态内容。高保真输出和流畅的动作表现,能有效吸引观众的注意力,提升广告效果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...